SpringFramework为与消息传递系统的集成提供了广泛的支持,从使用JmsTemplate简化JMSAPI的使用到异步接收消息的...SpringBoot也支持ApacheKafka。javax.jms.ConnectionFactory接口提供了一种创建javax.jms.Connectio

”apache kafka系列“ 的搜索结果

说明 kafka所有文章均基于版本 Kafka 2.2.0 java版本最低为Java 8 所有配置均使用默认 安装配置 下载解压 $ wget ...$ tar -xzf kafka_2.12-2.2.0.tgz $ cd kafka_2.12-...

正如我们在以前的博客中提到的,比如说我们的Docker系列博客,我们正处于把系统迁移到微服务新世界的过程中。促成这次架构改造的一项关键的技术就是ApacheKafka消息队列。它不仅成为了我们基础架构的关键组成部分,...

编者的话|本文来自 Nginx 官方博客,是微服务系列文章的第三篇,在第一篇文章中介绍了微服务架构模式,与单体模式进行了比较,并且讨论了使用微服务架构的优缺点。第二篇描述了采用微服务架构的应用客户端之间如何...

最近研究一下kafka,网上的这篇文章写得不错。就转载了

【大数据Kafka系列】Kafka简介

kafka简介ApacheKafka®是一个分布式流媒体平台。有三个关键功能:发布和订阅记录流,类似于消息队列或企业消息传递系统。以容错的持久方式存储记录流。记录发生时处理流。Kafka通常用于两大类应用:构建可在系统或...

「点击上方蓝色字体,选择“设为星标”回复”资源“获取更多资源科普时间首先,我们要来科普一下『边缘计算』。你去百度或者Google搜索,会有一大段的概念映入眼帘:在百度百科上:边缘计算,是指...

ApacheKafka 是一个分布式的流处理平台。它具有以下特点: 支持消息的发布和订阅,类似于 RabbtMQ、ActiveMQ 等消息队列; 支持数据实时处理; 能保证消息的可靠性投递; 支持消息的持久化存储,并通过多副本分布式...

ApacheKafka®是一个分布式流媒体平台。这到底是什么意思呢?我们认为流媒体平台具有三个关键功能:它可以让你发布和订阅记录流。在这方面,它类似于消息队列或企业消息传递系统。它允许您以容错方式存储记录流...

1.kafka简单介绍 kafka是linkedin使用Scala编写具有高水平扩展(只要增加服务器数量,就能线性扩充系统性能。)和高吞吐量(单位时间内处理的请求数量)的分布式消息系统 kafka对消息保存时根据Topic进行归类,发送消息...

一、事务场景 最简单的需求是producer发的多条消息组成一个事务这些消息需要对consumer同时可见或者同时不可见 。 producer可能会给多个topic,多个partition发消息,这些消息也需要能放在一个事务里面,这就...

ApacheKafka®是一个分布式流媒体平台。这到底是什么意思呢? 我们认为流媒体平台具有三个关键功能: 它可以让你发布和订阅记录流。在这方面,它类似于消息队列或企业消息传递系统。它允许您以容错方式存储记录...

与KafkaProducer不同的是,KafkaConsumer不是一个线程安全的类。为了便于分析,我们认为下面介绍的所有操作都是在同一线程中完成的,所以不需要考虑锁的问题。这种设计将实现多线程处理消息的逻辑转移到了调用Kafka...

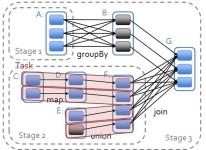

在阅读本文之前,读者最好已经阅读了《Spark2.1.0之初识Spark》和《Spark2.1.0之基础知识》两篇文章。本文将主要介绍Spark2.1.0版本中的模块设计以及各个模块的功能和特点。整个Spark主要由以下模块组成:Spark Core...

大数据平台架构及业务方案:

标签: 大数据

例如,使用Hadoop作为分布式文件系统的基础,利用Spark进行大数据处理和分析,选用Kafka作为消息队列来处理高速流动的实时数据,并采用HBase或Cassandra等NoSQL数据库来存储非结构化数据。数据清洗过程确保数据的...

目录 1.采用哪些方式可以获取大数据? 2.常用大数据采集工具有哪些? 3.简述什么是Apache Kafka数据采集。 4.Topic可以有多少个分区,这些分区有什么用? 5.Kafka抽象具有哪种模式...10.分别简述常用ETL工具...

智能设备连接到网络最早出现在1982年, Carnegie Mellon University改进的Coke machine成了第一个网络连接的机器,它可以报告自己的库存并且能够检测饮料是否是冰镇的。身边的thing连接到网络的世界正式拉开帷幕。...

kafka只是一个分为一个或多个分区的主题集合。kafka分区是线性有序的消息序列,其中每个消息由其索引(称为偏移量)标识。Kafka群集中的所有数据都是分区的不连贯的并集。传入的消息被写在分区的末尾,消息被消费者...

软件X 19(2022)101180原始软件出版物Commlib:一个易于使用的网络物理系统通信库放大图片创作者:Kristan L. 西梅翁电子和计算机工程学院,塞萨洛尼基亚里士多德大学,54124塞萨洛尼基,希腊ar t i cl e i nf o...

vcpkgC++开源项目1

springcloud

推荐文章

- GPT-ArcGIS数据处理、空间分析、可视化及多案例综合应用

- 在Debian 10上安装MySQL_debian mysql安装-程序员宅基地

- edge 此项内容已下载并添加到 Chrome 中。_一个小扩展,解决Chrome长期以来的大痛点...-程序员宅基地

- vue js 点击按钮为当前获得焦点的输入框输入值_vue获得当前获得焦点的元素-程序员宅基地

- Android 资源文件中@、@android:type、@*、?、@+含义和区别_@android @*android-程序员宅基地

- python中的正则表达式是干嘛的_Python中正则表达式介绍-程序员宅基地

- GeoGeo多线程_geo 多线程-程序员宅基地

- phpstudy的Apache无法启动_phpstudy apache无-程序员宅基地

- 数据泵导出出现ORA-31617错误-程序员宅基地

- java基础巩固-宇宙第一AiYWM:为了维持生计,两年多实验室项目经验之分层总结和其他后端开发好的习惯~整起_java两年经验项目-程序员宅基地